聴覚障害者というキーワードは意味を考えれば分かりますよね?

耳が聞こえなくなる障害を持つ意味を。

聴覚障害者、またはろう者に会って会話したことがありますか?

実際に体験した人は少ないと思います。

平成18年度のデータで古い話ですが、

日本の聴覚障害者数

- 18歳以上で34万3000人

- 18歳未満で1万5800人

- およそ1000人に3人が聴覚障害者である。

となっています。

さて、ろう者が悩むコミニュケーションの現状についてですが、コミュニケーションができる範囲は人によって違います。

耳が聞こえないけれど、発音が自由に喋れる。

耳が聞こえないけれど、手話ができない。

耳が聞こえないだけではなく、発音が不自由。

・・・など、コミュニケーション範囲がバラバラです。

ろう者と健聴者の間にあるコミュニケーションの壁

人間が持っている感覚全体、視覚、聴覚、触覚、味覚、嗅覚の「五感」を持っていますよね?

しかし、ろう者は五感の1つである聴覚が欠けています。

生活で必要な五感の中で特に必要な視覚と聴覚のどれか1つ欠いてしまうと予想以上の苦労がやってきます。

その中で特に苦労している悩み事を3つまとめていきたいと思います。

補聴器を付けると聞こえるから話せると勘違い

個人的には多分、一番多い悩み事だと思います。

補聴器は普通の声では聞こえない音量をろう者が聞こえる音量まで拡大する機械です。

ただし、音を大きくしても声を読み取れるとは限らないです。

聴覚障害に重度よるですが、ろう者の7割くらいは声を読み取れないと思います。

3割くらいは1対1の会話で相手の話を集中して聞けば、通訳なしで読み取れます。

最初から耳が聞こえる人からしたら「音を大きくすれば、言っていることは分かるだろう」と思いますよね?

全然違うんですよ、それが。

ハッキリしたことは分かりませんが、音を感じ取る神経と声を読み取る神経は別々だと思います。

ろう者は健聴者と比べて音を感じ取るのと声を読み取る神経が薄いか弱いかだと思います。

具体的に言うと・・・

- 聴覚障害の重度が重い場合音を感じ取る神経→補聴器で補う。声を読み取る神経→補っていない。

- 聴覚障害の重度が軽い場合音を感じ取る神経→補聴器で補う。声を読み取る神経→健聴者と変わらないので読み取れる?

だと思います。

そういった部分を知っている人は割と少ないので勘違いをする人が多いのが現状です。

電車の車内と避難と待ち合わせなどアナウンスが聞こえない

電車の車内、災害時の避難、病院の待ち合わせなど、どこかの拡声器からニュースや伝達事項を放送しますよね。

誰でも聞いたことがあるアナウンスのセリフといえば、

「お客様にお知らせいたします。ただ今車内の確認を行っております。ドアが開くまで、もうしばらくお待ちください。大変ご迷惑をおかけしております。」

「地震発生に伴う津波警報及び避難勧告が出ました。海岸線を避けて高台等へ避難して下さい。」

「会場内のお客様に迷子のご案内をいたします。青い色の服を着たB君を見かけた方お母さん・お父さんが探しておられます。心当たりの方は会場受付のテント前までご連絡下さい。また、お近くに居る様でしたら会場受付のテント前までお願いいたします。」

「Bさーん、2番診察室にお入りください。」

ですよね?

色んな場所に何か問題が起こっていたらアナウンスをします。

それを聞いて内容に従って行動をします。

しかし、声を読み取れないろう者は声が聞こえても言っている内容が分からないので混乱をします。

すると対応が遅れてしまいます。

健聴者の知り合いと一緒じゃないと対応が不可能なので悩んでいる人が多いと思っています。

緊急事態に電話ができない

盗難、または命にかかわる事故や事件など緊急事態が起こったらまず、スマホを取り出して110番か、119番で入力して警察、消防車、救急車を呼びますよね?

しかし、ろう者はそれが出来ないです。

先ほど話したサブタイトル、「補聴器を付けると聞こえるから話せると勘違い」と「電車の車内と避難と待ち合わせなどアナウンスが聞こえない」の2つを説明をしたのように聞こえていてもアナウンスの内容が分からないようじゃ、電話は不可能です。

周りに聞こえる人がいれば、その人に頼んで電話で呼んでもらうことができますが、いなかった場合はどうすればいいのか?すごく悩むはずです。

東京都内のみしか使えないですが、電話の代わりにスマホでアプリを利用して通報することができます。

そのアプリがfor Android(警視庁110番サイト通報アプリ )です。

Google playはこちらへ

App Storeはこちらへ

それ以外にクレジットカードに関して電話が必要になるときもありますよね?

イオンカード、楽天カード、オリコカード、dカードなど、買い物に使うクレジットカードが使えなくなった、失くしたとか問題があったときの連絡先が電話しか対応していない会社もあるので不便を感じる人がいるそうです。

電話に対応できない現状に似てるといえば、「マスクを外して口の形を見せてほしい」と悩む現状です。

マクドナルド、CoCo壱番屋、吉野家など、車を乗ったまま注文できるドライブスルーも電話で通話しているのと同じですよね?

マクスを付けたまま会話してると口の形が100%見えないからろう者にとっては電話をしているのと同じ感じで分からないと思います。

さて、話が多少ズレてしまいましたが、本題に入りたいと思います。

Error

第4次産業革命で手話コミュニケーションを増やしていく時代へ!

人工知能、仮想現実、5Gなど、新世代の技術で周りがアナログ式からデジタル式に変わっていく環境の中で手話の手段方法もデジタル化に進んでいます。

デジタル化に進んでいる手話コミュニケーションの技術を紹介したいと思います。

聾唖者の両親を持つ学生が開発している翻訳アプリ「拡張現実サインランゲージ」

拡張現実サインランゲージは、開発者であるニューヨーク大学の学生の両親がアメリカ手話に対して理解がなかったのがきっかけでした。

きっかけの流れとして・・・、

ニューヨーク大学に進学した香港人の学生と聾唖者の両親と共に香港からニューヨークへ引っ越しした。

引っ越し後、両親はニューヨークの環境を慣れるためにアメリカ人のろう者と交流をしてみようと思い、会ってみて手話をしてみたら今まで香港で手話していたやり方が通じないと感じた。

香港手話しか知らなかったため、アメリカ手話に関する理解がなかった。

アメリカ手話を覚えるのに苦戦中。

・・・だと思います。

アメリカ手話に苦戦している両親の様子を見た大学生は、聾唖者を対象としたインタビュー調査をしました。

調査の結果、モバイル環境にアクセスする機会が少ないのとデジタル技術を利用したシミュレーションが欲しいと求めていると分かりました。

そのきっかけで手話翻訳アプリの開発を決意しました。

聾唖者の第一言語は手話である。

聾唖者にとって手話は話し言葉よりも理解しやすい言語であるという考えに則りつつ、手話翻訳アプリの開発に携わった。

開発メンバーのひとりは、「聾唖者が何か言おうとする時、誰かに頼らざるを得ない。我々が開発したアプリがユーザーである聾唖者の自立を支えるツールになればと思う」と同大学の学生新聞の取材に対してコメントした。

手話は万国共通ではない。

同じ英語でもイギリス英語とアメリカ英語とでは異なるように、イギリス手話とアメリカ手話は全く別の言語である。

そのうえ中国手話、日本手話もあり、それぞれが独自の言語体系を有している。

「拡張現実サインランゲージ」は単に手話言語から話し言葉に変換するだけでなく、各国の手話言語間の翻訳にも対応している。

モバイル技術の進展とともに機械翻訳の技術は日々進歩し、未知の言語の翻訳が即座に手に入る時代へと突入した。

最新のニューラル機械翻訳モデルでは従来のルールベース機械翻訳に比べ高精度な翻訳を実現できるようになったとはいえ、

100パーセント正確な翻訳は不可能である。

もしかすると誤訳や訳抜けがあるかもしれない。

その点を留意の上で、手話翻訳アプリを活用する必要がある。

※ロボティアから引用

Verizon Connected Futures III – SOCIAL VR/AR – ARSL Presentation Final

プレゼンテーション動画を見て分かると思いますが、お客さん役と店員役がお互いスマホを取り出して手話翻訳アプリを起動します。

店員のほうから音声認識で話します。

するとテキストと手話シミュレーションが出てきます。

店員のコメントを確認したあと、お客さんから手話をするので手話を読み取れるようにちゃんとスマホでお客さんに向けています。

すると読み取った手話からテキスト化に変えて出てきます。

そんな感じで相手が手話を覚えなくてもすぐに相手に通じることができます。

今はまだ試作品ですが、100%に近い正確な翻訳ができるように開発をしています。

完成後、英語以外の手話言語も対応できるようにアップデートをするかもしれませんので楽しみですね。

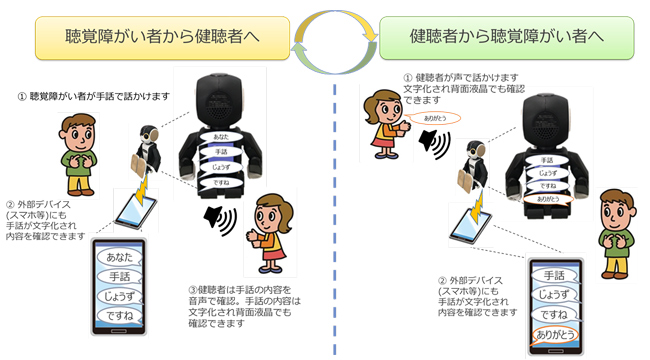

ロボホンで手話コミュニケーション手段を増やす。

シャープ社が開発したロボホンを手話通訳アプリケーションでコミュニケーション手段を増やすためにNTTデータ社と共同開発開始しました。

公式サイトはこちらへ

ロボホン向け手話通訳アプリケーション開発の内容は・・・、

【概要】

① コミュニケーション方法

・聴覚障がい者から健聴者への伝達ロボホンがAI技術(ディープラーニング)で聴覚障がい者の手話の動きを認識・分析して、手話の意味する単語を日本語で発話します。

また、発話した内容を外部デバイス(スマートフォンなど)に表示します。

・健聴者から聴覚障がい者への伝達ロボホンが健聴者の発話を認識して、その内容を外部デバイスに表示します。

② 手話の認識範囲

現在は、日本語対応手話の1種類を認識します。

今後、国際手話など認識できる種類の増加を予定しています。

③ 想定シーン

現段階:手話初学者の手話練習、単語レベルでの意思伝達交換。

今後:一連の手話を認識し簡単な会話での意思伝達交換、行政や企業の窓口応対。

となっています。

※シャープ株式会社のニュースリリースから引用しています。

開発中の様子を動画で投稿していますのでご覧ください。

【NTTデータ × SHARP】 ロボホン向け手話通訳アプリケーション

近い将来、ろう者を含めて大人数の会議でやるとき、ろう者専用の大きめのモニターと手話通訳アプリケーション付きのロボホンを設置して会議すれば、文字が見やすいし、今まで時間がかかっていた筆談をする必要がないのでスムーズに進められるようになると思います。

ソーシャルVR「VRChat」で仮想現実でも手話で会話できる!

VRChat(バーチャルリアリティチャット)は、自分で作ったアバター、または用意されたアバターを選択して仮想現実の世界に入ってチャットするVR版のSNSです。

公式サイトはこちらへ

アバターだけではなく、自分専用のチャットルームも作れます。

自作アバター作成方法は、VRchat 日本wikiから説明してくれます。

自分でこんな風景にしたい!こんな部屋にしたい!と思ったら作れる世界です。

例としてワールド一覧を紹介しているサイトがありますのでご覧なったほうが早いです。

「VRChatの世界」を運営している者のツイッターもありますのでこちらへ

さて、なぜ、VRChatを紹介したのかというと、ツイッターである話題が出てきたからです。

聴覚障害持ち(Deaf)のフレンドの誕生日で少しお邪魔した

手話で会話していました

VRChatすごい pic.twitter.com/qocqRwWJ0y— あんどら (@Anndora_chan) 2019年3月3日

仮想現実でどうやって手話をしているのか?というと・・・

手の動きは実際にやって、指の形だけコントローラーのボタンで入力しているんです

手話ができればリアルでやるのと変わらないので簡単だと思いますよ— クロワサ (@0_523307) 2019年3月3日

すみません、指文字だけキー入力ってことですかね?

— ビットミー (@bihhtmy) 2019年3月3日

手話便利ですよー。うるさい場所や静かで喋れない場所で意思疎通が出来るので。健常者にもオヌヌメです(´-`三´-`) と言いつつ私もあまり出来ないので、動画は早すぎて何言ってるか分かりませんでしたw

— ビットミー (@bihhtmy) 2019年3月4日

コントローラーで動作をしてるそうです。

今はないですが、翻訳アプリ「拡張現実サインランゲージ」のようにキーボードで手話に変換したり、国が違う手話をテキストで通訳をしてくれるVRChat向け製品を開発してくれる人がいたら利用しているろう者が一気に増えるでしょう。

以上になりますが、健聴者とろう者の間にあるコミュニケーションがデジタル化に進み、時間効率化ができるようになるので完成したデジタル式の手話コミュニケーションが見れる未来が楽しみです。

Error